Искусственный интеллект развивается быстрее, чем любая другая сфера IT, а требования к оборудованию растут ежегодно. Компании, создающие модели, обучающие нейросети или запускающие сложные LLM-приложения, сталкиваются с вопросом: какие серверы лучше всего подходят для AI и какие видеокарты выбрать?

В этой статье мы разберём, какое оборудование оптимально для разных типов AI-нагрузок, какие GPU использовать, и как правильно выбирать сервер для машинного обучения, инференса и генеративных моделей.

Искусственный интеллект уже давно перестал быть экспериментальной технологией и стал фундаментом современной цифровой экономики. То, что ещё десять лет назад воспринималось как научная фантастика, сегодня используется в повседневных сервисах: от рекомендаций в соцсетях до нейросетей, создающих изображения, видео и тексты на уровне профессиональных дизайнеров и копирайтеров. Развитие AI прошло удивительный путь, и ключевую роль в этом прогрессе сыграли не только алгоритмы, но и вычислительная инфраструктура, которая сделала возможным обучение моделей с миллиардами параметров.

Первые поколения нейросетей работали на обычных CPU, поскольку сами модели были относительно небольшими, а объёмы данных — ограниченными. Но с ростом интереса к deep learning стало ясно, что традиционные процессоры просто не способны эффективно выполнять множество параллельных операций, необходимых для обучения глубоких архитектур. Появление GPU стало переломным моментом: параллельная структура графических процессоров идеально подошла для матричных вычислений, лежащих в основе современных нейросетей. Именно поэтому переход на GPU ускорил обучение моделей в сотни раз и открыл путь к созданию систем уровня AlphaGo, больших трансформеров и генеративных моделей нового поколения.

С каждым годом объёмы данных росли, и архитекторы ИИ стремились создавать более глубокие, широкие и сложные модели. Появились огромные датасеты для изображения, текстов и видео, а затем и трансформеры, которые кардинально изменили весь ландшафт AI. Модели вроде BERT, GPT, LLaMA и Mistral стали возможны только благодаря тому, что вычислительная инфраструктура развивалась не менее стремительно, чем сами алгоритмы. Инженеры столкнулись с необходимостью соединять видеокарты в единую систему, увеличивать пропускную способность между ними, улучшать охлаждение и обеспечивать огромный объём видеопамяти, без которого обучение современных моделей просто невозможно.

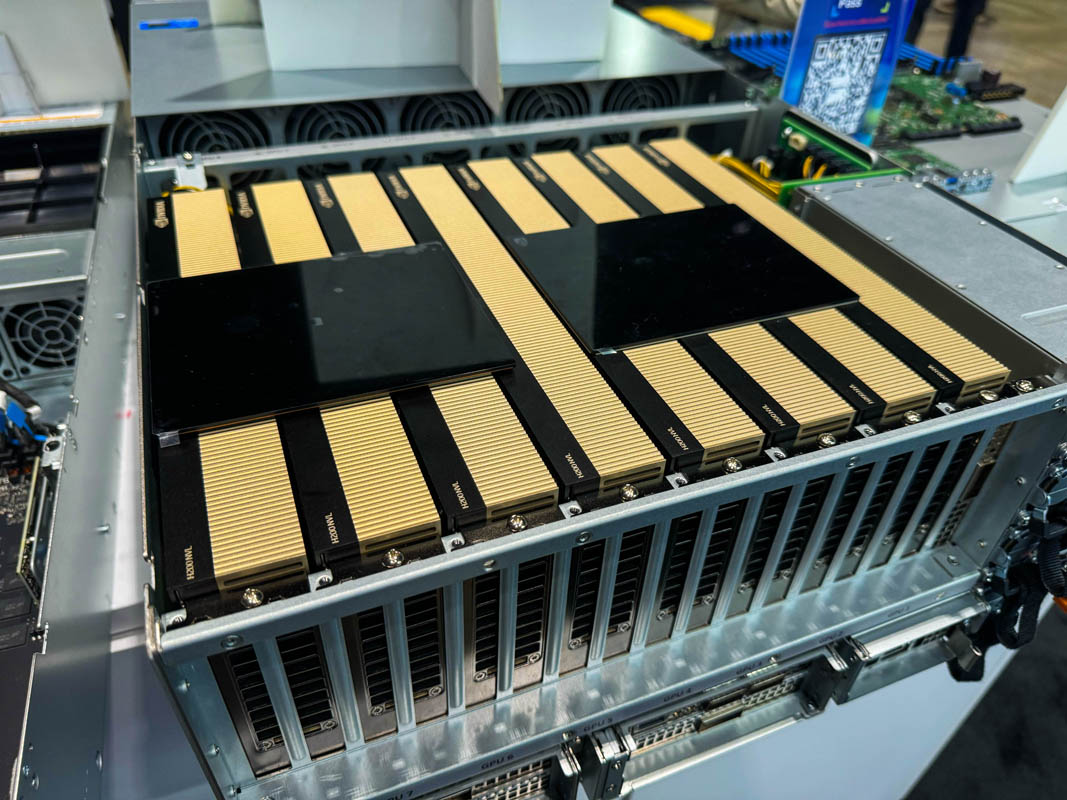

Со временем стало понятно, что нейросетям недостаточно быть просто мощными — они должны быть гибкими, доступными и масштабируемыми. Для этого появились специализированные GPU вроде NVIDIA A100, H100, L40S и RTX 6000 Ada, которые стали стандартом для индустрии искусственного интеллекта. Эти видеокарты созданы специально для задач машинного обучения: они поддерживают ускоренные тензорные вычисления, высокие пропускные способности и большие объёмы VRAM, что позволяет работать с моделями, чьи размеры достигают сотен миллиардов параметров.

Но даже лучшие GPU не могут раскрыть свой потенциал без правильно подобранного серверного окружения. Современные AI-сервера — это не просто "компьютеры с видеокартами". Это тщательно продуманная инфраструктура, где каждая деталь — от CPU до пропускной способности PCIe — влияет на конечную скорость обучения и инференса. Для больших моделей критически важны NVLink и NVSwitch, позволяющие GPU обмениваться данными напрямую и работать как единый вычислительный модуль. Для инференса важна энергоэффективность и оптимальное сочетание производительности и цены. Для генеративной графики и компьютерного зрения — высокий FP16/FP32 перформанс. Каждое направление AI требует своего уникального подхода к выбору серверов.

Развитие AI теперь невозможно отделить от развития технической базы. Именно поэтому выбор правильного GPU-сервера стал не менее важным, чем выбор модели или фреймворка. Компании, исследователи, стартапы и лаборатории сталкиваются с задачей подобрать оборудование, которое позволит обучить модель быстрее конкурентов, сократить время вывода в прод и обеспечить экономическую эффективность проекта. Сегодня серверы для AI — это фундамент, на котором строятся все современные интеллектуальные системы.

Почему сервер для AI должен быть особенным?

AI-нагрузки отличаются от обычных вычислительных задач:

Высокая параллельность

Обучение нейросетей отлично масштабируется за счёт GPU, поскольку тысячи ядер могут выполнять операции параллельно.Большие объёмы данных

Модели LLM, CV и NLP требуют пропускать через себя гигабайты/терабайты данных.Огромные требования к памяти

Современные модели (LLaMA, GPT-подобные, Stable Diffusion XL, Video AI) требуют десятки гигабайт видеопамяти.Высокая пропускная способность между GPU

Для multi-GPU обучение важен NVLink или NVSwitch — чем быстрее обмен, тем короче время обучения.

Серверы для обучения нейросетей (Deep Learning / LLM training)

Лучшие GPU (на 2025 год):

NVIDIA H100/H200 — лучший вариант для индустриального обучения больших моделей.

NVIDIA A100 (40/80GB) — золотой стандарт для большинства AI-лабораторий.

NVIDIA L40S — мощная альтернатива, подходит для больших моделей, но без NVLink не лучший выбор для multi-GPU обучения.

Рекомендованные конфигурации серверов:

4× или 8× GPU с NVLink/NVSwitch

CPU: Intel Xeon Scalable Gold или AMD EPYC 7xx4 (Rome/Milan/Genoa)

RAM: минимум 256–512GB

NVMe: от 2–8TB, лучше PCIe 4.0/5.0

Сеть: 25–100GbE или Infiniband HDR/NDR

Для каких задач:

Обучение LLM (LLaMA, Falcon, Mistral)

Обучение Vision Transformers

Обучение больших GAN/Video AI моделей

Многоузловые распределённые кластеры

Почему важен NVLink?

Обучение больших моделей требует обмена гигабайтами градиентов между видеокартами. Если GPU не связаны NVLink/NVSwitch, обучение замедляется в 5–15 раз.

Серверы для инференса моделей (LLM, API, Chatbots)

Если вы не обучаете модель с нуля, а только запускаете ответы в проде:

Лучшие GPU для инференса:

L40S — лидер по эффективности цена/производительность в LLM workload.

A100 40/80GB — стабильный вариант для больших моделей.

A30 — бюджетное решение, подходящее для LLaMA-13B/70B после квантования.

RTX 6000 Ada — высокая производительность, доступная в single-GPU серверах.

Рекомендованные серверы:

1–2 GPU без NVLink (если модель помещается в память)

RAM: 128–256GB

NVMe: 1–2TB

Энергоэффективные CPU (Xeon Gold, EPYC 7313/7413/75xx)

Для каких задач:

GPT-подобные чат-боты

Встраивание и обработка текста

API для LLM в проде

Голосовые ассистенты

Code-completion сервисы

На что смотреть?

объём видеопамяти — инеренс Llama-70B FP16 требует ~140GB VRAM

пропускная способность памяти

PCIe 4.0 / 5.0

Серверы для Computer Vision (CV): детекция, сегментация, видеоаналитика

Лучшие GPU:

RTX 6000 Ada — топ для видеоаналитики и CV.

L40 или L40S — идеальны для компьютерного зрения.

A40 — энергоэффективное решение для кластеров.

A2/A10 — для лёгких моделей и edge-серверов.

Рекомендованные конфигурации:

1–4 GPU, NVLink обычно не нужен

RAM: 128–256GB

Хранилище: NVMe + массивы для видеопотоков

Дополнительно: аппаратные энкодеры/декодеры (NVENC/NVDEC)

Почему RTX 6000 Ada — топ для CV?

высокая производительность FP32

48GB VRAM — достаточно для самых «тяжёлых» моделей

мощный тензорный блок Ada Lovelace

Для каких задач:

Системы видеонаблюдения

Обнаружение объектов

Face recognition

OCR

Видеопотоки 4K/8K

Серверы для генеративной графики, 3D и Stable Diffusion

Создание изображений, видео, 3D сцен требует GPU с высокой FP16/FP8 мощностью.

Лучшие GPU:

RTX 6000 Ada — самый быстрый вариант для SDXL и Video AI.

L40S — мощное и универсальное решение.

A100 — подходит для heavy workloads.

4090 — лучший потребительский вариант (если допустимо использование consumer-GPU).

Рекомендации:

VRAM: минимум 24–48GB

NVMe: 2–8TB для моделей и датасетов

RAM: 128GB

Для каких задач:

Stable Diffusion XL

Video Diffusion

3D/NeRF

Upscaling/Restoration

VFX и CGI

Как выбрать сервер под ваш тип AI?

Если обучаете большие модели → H100 / A100 / 8×GPU

Главное — NVLink и много VRAM.Если нужен инференс LLM → L40S / A100 / RTX 6000 Ada

Оптимальны по цене и эффективности.Если это CV / видеоаналитика → RTX 6000 Ada / L40

Сильные по FP32 и NVENC/NVDEC.Если генеративная графика → RTX 6000 Ada / L40S / 4090

Максимальная вычислительная мощность.Если нужен недорогой GPU сервер → A10 / A30 / A40

Крайне сбалансированы для среднего бизнеса.

Мы понимаем, насколько важно подобрать решение, которое полностью соответствует потребностям конкретного проекта. Поэтому мы предлагаем серверы с самыми современными GPU — от RTX 6000 Ada и L40S до A100 и H100 — и помогаем клиентам определиться с оптимальной конфигурацией. Независимо от того, обучаете ли вы большие языковые модели, запускаете генеративную графику, работаете с видеоаналитикой или создаёте продакшн-сервис на базе LLM, мы можем предложить сервер, который обеспечит максимальную производительность и стабильность.